Inteligencia Artificial

Crean música a partir de los pensamientos humanos

Se parece semánticamente al estímulo musical original, aunque la letra resulta ininteligible

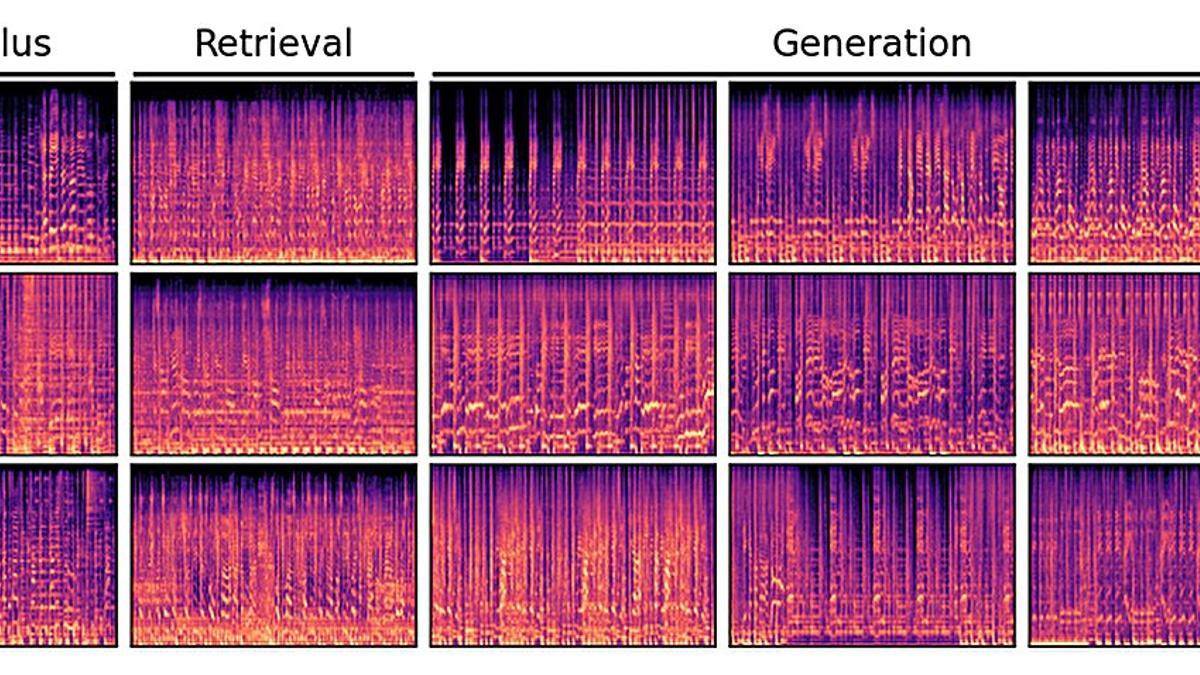

Espectrogramas de diferentes clips de música escuchados durante el experimento. / arXiv (2023).

Redacción T21

La Inteligencia Artificial ha conseguido crear música a partir de los registros cerebrales obtenidos mientras unos voluntarios escuchaban fragmentos de hasta 10 géneros musicales. La música así recreada se parece a los estímulos musicales originales, pero la letra es ininteligible porque la tecnología, todavía, no la tiene en cuenta.

¿Se puede crear música solo con pensarla? Pues esto es lo que han logrado investigadores de Google y la Universidad de Osaka en Japón, utilizando la inteligencia artificial (IA) para reconstruir música a partir de la actividad cerebral humana. Los resultados de esta investigación se han publicado en arXiv.

Los investigadores utilizaron muestras de música que abarcan 10 géneros, incluyendo rock, clásica, metal, hip-hop, pop y jazz, y se las hicieron escuchar a cinco sujetos mientras observaban su actividad cerebral.

Registraron las lecturas de resonancia magnética funcional (fMRI) mientras escuchaban. Las lecturas de fMRI, a diferencia de las de MRI, registran la actividad metabólica a lo largo del tiempo.

Las lecturas se utilizaron luego para entrenar a una red neuronal profunda que identificó actividades neuronales vinculadas a diversas características de la música, como el género, el estado de ánimo y la instrumentación.

Paso intermedio

Un paso intermedio trajo al estudio MusicLM. Este modelo, diseñado por Google, genera música basada en descripciones de texto. Al igual que las fMRI, mide factores como la instrumentación, el ritmo y las emociones.

Un ejemplo de entrada de texto que genera MusicLM es: "Canción meditativa, calmante y relajante, con flautas y guitarras. La música es lenta, con un enfoque en crear una sensación de paz y tranquilidad".

Los investigadores vincularon la base de datos de MusicLM con las lecturas de fMRI, permitiendo que su modelo de IA reconstruyera la música que los sujetos habían escuchado. En lugar de instrucciones de texto, la actividad cerebral proporcionó el contexto para la salida musical.

Música equivalente

Los investigadores llamaron a su modelo de IA Brain2Music. "Nuestra evaluación indica que la música reconstruida se parece semánticamente al estímulo musical original", explica Timo Denk, uno de los autores de esta investigación, citado por Techxplore

"La música generada se parece a los estímulos musicales que experimentaron los sujetos humanos, con respecto a propiedades semánticas como el género, la instrumentación y el estado de ánimo", añade.

Además, identificaron regiones cerebrales que reflejan información procedente de descripciones textuales de música.

Los ejemplos proporcionados por el equipo demuestran extractos de música sorprendentemente similares interpretados por Brain2Music basados en las ondas cerebrales de los sujetos.

Letra pendiente

¡Una de las canciones muestreadas fue uno de los primeros éxitos del Top 10 del año 2000, “Oops!... I Did It Again", de Britney Spears.

Varios de los elementos musicales de la canción, como el sonido de los instrumentos y el ritmo, coincidían estrechamente, aunque la letra era ininteligible. La tecnología se centra en la instrumentación y el estilo, no en las letras, explicaron los investigadores.

"Este estudio es el primero en proporcionar una interpretación cuantitativa desde una perspectiva biológica", dijo Denk. Pero reconoció que, a pesar de los avances en los modelos de texto a música, "sus procesos internos aún no se conocen bien".

La IA aún no está lista para acceder a nuestros cerebros y escribir melodías perfectamente orquestadas, pero ese día puede no estar muy lejos, concluyen estos investigadores.

Posibles aplicaciones

Las posibles aplicaciones de esta investigación son muy variadas e innovadoras. Podría permitir a las personas crear música personalizada según sus preferencias y estados emocionales.

También podría ayudar a personas con discapacidades o trastornos neurológicos a expresarse musicalmente sin necesidad de instrumentos o interfaces físicas.

Además, podría abrir nuevas vías para el estudio y la comprensión del cerebro humano y su relación con la música.

Referencia

Brain2Music: Reconstructing Music from Human Brain Activity. Timo I. Denk et al. arXiv:2307.11078v1 [q-bio.NC]. DOI:https://doi.org/10.48550/arXiv.2307.11078

- Una extraña y antigua megaestructura acecha bajo el mar Báltico

- Decodifican con IA las conversaciones entre arañas

- El crecimiento imparable de la población humana toca a su fin

- Los electrones abren un nuevo mundo a la física cuántica

- Algo extraño ocurre en el Cometa Diablo que nos visita durante el eclipse solar de abril

- El Alzheimer podría transmitirse mediante transfusiones de sangre y trasplantes de órganos

- La memoria “daña” al cerebro a largo plazo

- Descubren el primer hogar del Homo Sapiens fuera de África